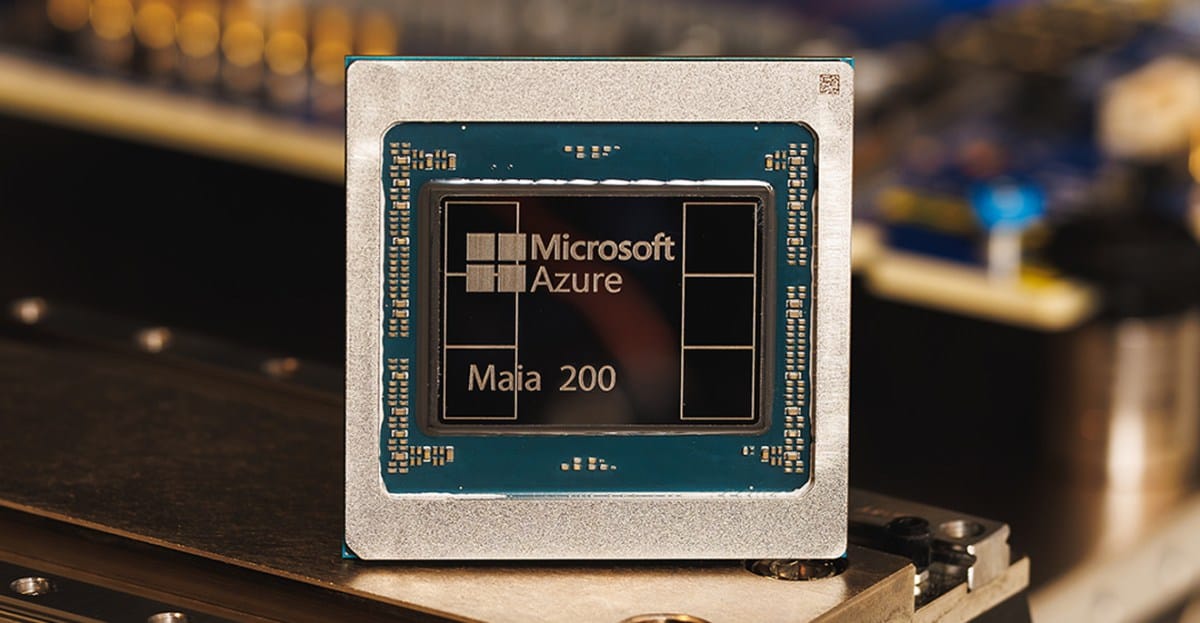

Microsoft आज अपनी पहली इन-हाउस AI चिप के उत्तराधिकारी Maia 200 की घोषणा कर रहा है। TSMC की 3nm प्रक्रिया पर निर्मित, Microsoft का कहना है कि उसका Maia 200 AI त्वरक “तीसरी पीढ़ी के अमेज़ॅन ट्रेनियम के FP4 प्रदर्शन से 3 गुना अधिक और Google की सातवीं पीढ़ी के TPU से ऊपर FP8 प्रदर्शन प्रदान करता है।”

प्रत्येक Maia 200 चिप में 100 बिलियन से अधिक ट्रांजिस्टर हैं, जो सभी बड़े पैमाने पर AI कार्यभार को संभालने के लिए डिज़ाइन किए गए हैं। माइक्रोसॉफ्ट के क्लाउड और एआई डिवीजन के कार्यकारी उपाध्यक्ष स्कॉट गुथरी कहते हैं, “मैया 200 आज के सबसे बड़े मॉडलों को आसानी से चला सकता है, भविष्य में और भी बड़े मॉडलों के लिए पर्याप्त गुंजाइश के साथ।”

Microsoft, OpenAI के GPT-5.2 मॉडल और अन्य को Microsoft फाउंड्री और Microsoft 365 Copilot के लिए होस्ट करने के लिए Maia 200 का उपयोग करेगा। गुथरी कहते हैं, “मैया 200 माइक्रोसॉफ्ट द्वारा अब तक तैनात की गई सबसे कुशल अनुमान प्रणाली है, जो आज हमारे बेड़े में नवीनतम पीढ़ी के हार्डवेयर की तुलना में प्रति डॉलर 30 प्रतिशत बेहतर प्रदर्शन के साथ है।”

अपने करीबी बिग टेक प्रतिस्पर्धियों की तुलना में माइक्रोसॉफ्ट का प्रदर्शन उस समय से अलग है जब उसने पहली बार 2023 में Maia 100 लॉन्च किया था और वह अमेज़ॅन और Google की AI क्लाउड क्षमताओं के साथ सीधे तुलना में नहीं आना चाहता था। हालाँकि, Google और Amazon दोनों अगली पीढ़ी के AI चिप्स पर काम कर रहे हैं। अमेज़न सम है ai-infrastructure-with-nvidia-nvlink-fusion-for-trainium4-deployment/">एनवीडिया के साथ काम करना अपनी आगामी ट्रेनियम4 चिप को एनवीलिंक 6 और एनवीडिया के एमजीएक्स रैक आर्किटेक्चर के साथ एकीकृत करने के लिए।

Microsoft की सुपरइंटेलिजेंस टीम अपने Maia 200 चिप्स का उपयोग करने वाली पहली टीम होगी, और कंपनी Maia 200 सॉफ़्टवेयर डेवलपमेंट किट के शुरुआती पूर्वावलोकन के लिए शिक्षाविदों, डेवलपर्स, AI प्रयोगशालाओं और ओपन-सोर्स मॉडल प्रोजेक्ट योगदानकर्ताओं को भी आमंत्रित कर रही है। Microsoft आज इन नए चिप्स को अपने Azure US सेंट्रल डेटा सेंटर क्षेत्र में तैनात करना शुरू कर रहा है, जिसके बाद अतिरिक्त क्षेत्र भी आएंगे।

microsoft-maia-200-ai-chip-announcement">Source link